메모리가 모자라서 생기는 문제였다.

필요없는 메모리를 삭제하기로 결정했다.

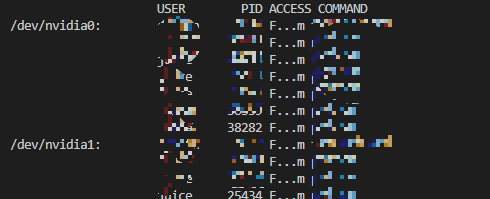

sudo fuser -v /dev/nvidia*cuda를 쓰고 있는 메모리들 확인이 가능하다.

sudo kill -9 PID안쓰는 메모리들을 kill해주면 쓸 수 있는 메모리가 많아져 다시 코드를 돌릴 수 있다.

'Pytorch' 카테고리의 다른 글

| VS Code에서 pytorch 사용을 위한 python 환경 설정 (0) | 2022.12.16 |

|---|

메모리가 모자라서 생기는 문제였다.

필요없는 메모리를 삭제하기로 결정했다.

sudo fuser -v /dev/nvidia*cuda를 쓰고 있는 메모리들 확인이 가능하다.

sudo kill -9 PID안쓰는 메모리들을 kill해주면 쓸 수 있는 메모리가 많아져 다시 코드를 돌릴 수 있다.

| VS Code에서 pytorch 사용을 위한 python 환경 설정 (0) | 2022.12.16 |

|---|

해당 논문은 IoT 및 웨어러블 기기에서 수집된 시계열 데이터의 주석 작업의 어려움을 강조하면서 여기서 (사람이) 인식 가능한 패턴을 찾는 것이 어렵다는 것에 대해 문제를 야기합니다.

지도 학습 기반의 딥러닝 방법은 일반적으로 훈련에 많은 양의 주석이 달린 데이터를 필요로 하기 때문에, 시계열 데이터에 이를 적용하는 것은 어려움이 있습니다. 자기 지도 학습(Self-supervised Learning)은 주석이 없는 데이터로부터 효과적인 표현을 추출하기 위한 방법으로 주목받고 있습니다. 자기 지도 학습으로 훈련된 사전 훈련 모델은 제한된 주석이 달린 데이터로도 비슷한 성능을 달성할 수 있습니다. 여러 가지 자기 지도 학습 접근 방식은 퍼즐을 푸는 것이나 이미지 회전을 예측하는 것과 미리 정해진 태스크를 기반으로 사전 학습하는데 이러한 방식은 학습된 표현의 일반성을 제한할 수 있습니다.

대조 학습은 증강된 데이터로부터 불변한 표현을 학습하는 자기 지도 학습 기법으로, 동일 샘플의 다른 관점 간 유사성을 극대화하고 다른 샘플의 관점과의 유사성을 최소화합니다. 그러나 기존의 이미지 기반 대조 학습 방법은 시계열 데이터에는 잘 작동하지 않습니다. 이는 시계열 데이터의 시간적 종속성을 다루지 못하고 이미지 증강 기술과 시계열 데이터 간의 불일치 때문입니다. 시계열 데이터에 대한 대조 학습 방법은 몇 가지 제안되었지만, 특정 응용 프로그램을 위한 것이 주로이며 일반화가 부족합니다.

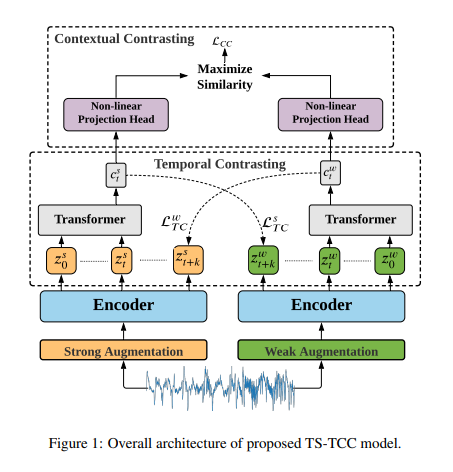

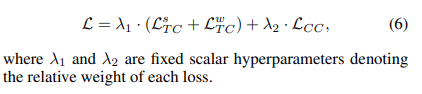

이러한 도전을 극복하기 위해 저자들은 시계열 데이터에 맞춰진 단순하고 효율적인 데이터 증강을 사용하는 "시계열 및 문맥 대조를 통한 시계열 표현 학습 프레임워크(TS-TCC)"를 제안합니다.

이 프레임워크는 입력 데이터의 두 가지 상관된 관점을 만들기 위해 데이터 증강을 활용합니다.

시간 대조 모듈을 도입하여 견고한 표현을 학습하기 위한 어려운 교차 관점 예측 작업을 설계합니다. 이 모듈은 한 시간 단계에 대해 한 증강의 과거 잠재 특징을 다른 증강의 미래를 예측하는 데 사용하여 모델이 다른 시간 단계와 증강에 의해 도입되는 견고한 표현을 학습하도록 합니다.

또한, 시간 대조 모듈에 의해 학습된 견고한 표현을 기반으로 판별적인 표현을 학습하기 위해 문맥 대조 모듈을 제안합니다. 이 문맥 대조 모듈은 동일한 샘플의 다른 문맥 간 유사성을 극대화하고 다른 샘플의 문맥 간 유사성을 최소화하는 것을 목표로 합니다.

GitHub - emadeldeen24/TS-TCC: [IJCAI-21] "Time-Series Representation Learning via Temporal and Contextual Contrasting"

[IJCAI-21] "Time-Series Representation Learning via Temporal and Contextual Contrasting" - GitHub - emadeldeen24/TS-TCC: [IJCAI-21] "Time-Series Representation Learning via Temporal ...

github.com

https://arxiv.org/pdf/2106.14112.pdf

| [NeuraIPS' 23] Self-supervised Contrastive Pre-training for time series via Time-Frequency Consistency 공부 (0) | 2023.05.17 |

|---|

해당 논문은 임상 진단, 교통 분석, 기후 과학 등 다양한 분야에서 시계열의 중요성에 대해 논의합니다.

표현 학습은 시계열 분석을 크게 발전시켰지만, 시간적 데이터에 대한 일반화 가능한 표현 학습은 여전히 어려운 문제로 남아 있어요.

다양한 데이터셋에서 신경망 모델을 사전 훈련함으로써 새로운 시계열 데이터에 대한 일반화를 향상시킬 수 있지만, 이러한 접근법은 종종 분포 변화, 사전 훈련 중 알 수 없는 타겟 데이터셋의 특성 등의 이유로 실패할 수 있습니다. 또한, 시계열의 복잡성으로 인해 지식 이전을 위한 유용성이 제한될 수 있죠.

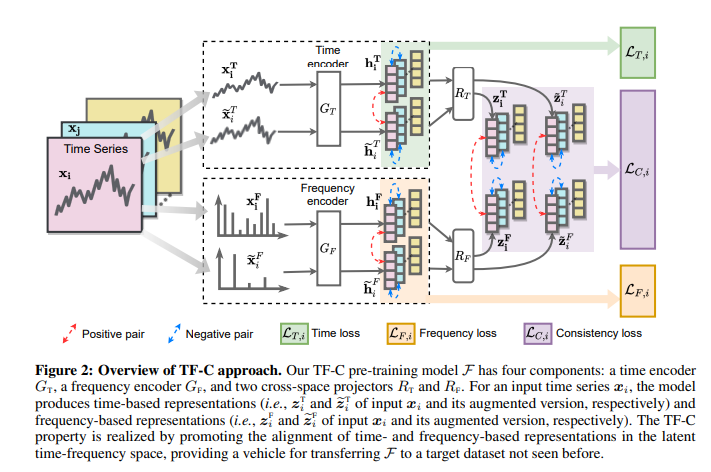

해당 논문에서는 시계열 데이터에 대한 일반화 가능한 표현을 생성하기 위해 새로운 시간-주파수 일관성 원칙을 적용한 방법론을 제안합니다.

이 원칙은 동일한 시계열 샘플에서 학습한 시간 기반 및 주파수 기반 표현이 다른 시계열 샘플에서 발생된 표현들보다 시간-주파수 공간에서 더 가까워야 한다는 것을 의미합니다.

제안된 방법은 시간 공간에서 대조적 학습을 채택하여 시간 기반 표현을 생성하고, 주파수 스펙트럼의 특성을 기반으로 한 일련의 새로운 보강을 통해 대조적 인스턴스 구별을 통해 주파수 기반 표현을 생성합니다.

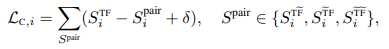

또한 제안된 시간-주파수 일관성 원칙을 활용하여 같은 샘플에서 발생한 시간 표현과 주파수 표현을 가깝게 하고 나머지는 멀어질 수 있도록 대조적인 학습을 합니다.

사전 훈련 목표는 시간 기반 및 주파수 기반 표현 사이의 거리를 최소화하는 것이며, 이를 위해 새로운 일관성 손실을 사용합니다. 사전 학습된 모델 파라미터에 인코딩된 학습된 표현 간의 관계는 타겟 데이터셋에 모델을 이전하여 성능을 향상시킵니다.

제안된 시간-주파수 일관성 원칙을 활용한 시계열의 자기 지도 학습 사전 훈련 전략은 대량의 주석이 달린 데이터셋의 부족과 같은 지도 학습 사전 훈련의 한계를 극복하고, 이전에 본 적 없는 대상 데이터셋에 대한 지식 이전을 용이하게 할 수 있음을 증명하였답니다.

Self-Supervised Contrastive Pre-Training For Time Series via Time-Frequency Consistency

Pre-training on time series poses a unique challenge due to the potential mismatch between pre-training and target domains, such as shifts in temporal dynamics, fast-evolving trends, and long-range and short-cyclic effects, which can lead to poor downstrea

arxiv.org

GitHub - mims-harvard/TFC-pretraining: Self-supervised contrastive learning for time series via time-frequency consistency

Self-supervised contrastive learning for time series via time-frequency consistency - GitHub - mims-harvard/TFC-pretraining: Self-supervised contrastive learning for time series via time-frequency ...

github.com

| [IJCAI' 21] Time-Series Representation Learning via Temporal and Contextual Contrasting 공부 (0) | 2023.05.18 |

|---|

Git clone을 하다가 안 되는 문제에 봉착했다.

local에서 한동안 git 정리를 안 했더니

문제가 생겼다.

아마 origin으로 필요없는 연결까지 시켜놓은 탓인 듯 하여

git remote -v

git remote remove origin를 이용하여 현재 연결되어 있는 git를 다 끊어봤는데 읭...? 안된다.

origin이 제거가 안 된다.

찾아보니... global에서 origin 문제가 생긴 듯하다.

git config --list를 해서 git global 속성들을 확인할 수 있다.

여기에 remote origin main과 관련되어 미리 세팅되어 있어서 생긴 문제였다;;

git config --global --unset 속성을 해서 모든 관련 속성을 지웠더니 잘 clone 되는 것을 확인할 수 있었다.